Vergessen ist ein fester Bestandteil unseres Alltags. Wir vergessen Termine, vergessen die PIN unserer Bankkarte oder vergessen Kevin allein zu Haus, wenn wir in den Urlaub fliegen. Das alles kann katastrophale Folgen haben. Im Folgenden erläutern wir kurz, welchen Zweck diese vermeintliche Fehlfunktion unseres Gedächtnisses erfüllt. Anschließend betrachten wir Vergessen im Kontext des Maschinellen Lernens und erklären, warum es zu einer neuen Grundanforderungen für Modelle in der Praxis werden könnte.

Warum vergessen Menschen?

Um diese Frage zu beantworten, müssen wir klären welche Prozesse in unserem Gehirn für das Vergessen verantwortlich sind und welchen Zweck diese erfüllen. Hiermit beschäftigen sich unter anderem Forschende der Psychologie, Neurobiologie und Psychopharmakologie bereits seit über 100 Jahren. Eine der wohl am weitesten akzeptierten Erklärungen für die Ursache des Vergessens ist die der Interferenztheorie. Diese beschreibt den Prozess des Vergessens als Konkurrieren von bestehenden Erinnerungen und kürzlich erworbenen Informationen. So kann das Bilden von neuen Erinnerungen aufgrund anderer bereits bestehender Assoziationen erschwert oder sogar verhindert werden (proaktive Interferenz). Weitaus relevanter ist allerdings die retroaktive Interferenz, bei der das Erinnern an ältere Informationen durch kürzlich erworbene Informationen gehemmt wird. Beispielsweise lässt sich das nötige Wissen während einer Prüfungssituation schlechter abrufen, wenn man kurz vor der Prüfung noch etwas über einen anderen Themenbereich gelernt hat. Das kürzlich Erlernte interferiert dann retroaktiv mit den prüfungsrelevanten Informationen.

Eng verbunden mit der Interferenztheorie ist die sogenannte Konsolidierung. Diese beschreibt, dass neue Erinnerungen beziehungsweise Informationen nach ihrer Aufnahme Zeit benötigen, um sich festigen zu können. Die Festigung bestimmt maßgeblich, ob und wie einfach eine Erinnerung später wieder abrufbar ist. Wie gut eine Information gefestigt wird, ist abhängig von verschiedenen körperlichen und geistigen Faktoren oder der retroaktiven Interferenz durch andere Reize. So wird eine Information vermutlich weniger gut gefestigt, wenn diese im betrunkenen oder müden Zustand aufgenommen wird.

So lästig Vergessen für die meisten von uns auch sein mag, ist es kein Fehlverhalten unseres Gedächtnisses, sondern eine essenzielle Kernfunktion. Diese hilft uns dabei die große Menge an Reizen, die sekündlich auf uns einwirken, zu verarbeiten, von spezifischen Informationen unnötige Details zu entfernen und somit generelle Konzepte zu entwickeln. Das Vergessen ist somit ein ausschlaggebender Faktor dafür, wie gut wir uns an eine neue Situation anpassen können. Aus Perspektive des Maschinellen Lernens ist dieses Phänomen eng verwandt mit der Generalisierungsfähigkeit und der Überanpassung (engl. Overfitting) von Modellen.

Vergessen im Maschinellen Lernen

Das Konzept des Vergessens ist im Bereich des Maschinellen Lernens bisher nur wenig erforscht und die meisten Publikationen befassen sich mit dem sogenannten Catastrophic Forgetting, manchmal auch Catastrophic Interference genannt. Wie der Name schon vermuten lässt, wird hier das Vergessen als eine negative Eigenschaft aufgegriffen. Dabei vergisst ein Modell durch das Verarbeiten neuer Daten das Wissen über zuvor betrachtete Daten. Dieses Phänomen ist besonders problematisch bei Modellen, die sequentiell das Lösen verschiedener Aufgaben erlernen (Multi-Task Lernen). Intuitiv kann das Catastrophic Forgetting auch als gescheiterte Festigung des Wissens aufgrund retroaktiver Interferenz betrachtet werden.

Nur wenige der existierenden wissenschaftlichen Publikationen befassen sich allerdings damit, wie Vergessen im maschinellen Lernprozess gezielt eingesetzt werden kann, um bereits gelernte Informationen zu entfernen. Doch warum sollten wir überhaupt gezielt etwas vergessen wollen? Betrachten wir dazu ein kleines Beispiel.

2018 trat die Datenschutzgrundverordnung (DSGVO) in der EU in Kraft, die unter anderem auch das Recht auf Vergessenwerden formuliert. Ähnliche Vorgaben existieren beispielsweise auch in den USA und Japan. Vereinfacht gesagt müssen Organisationen, die personenbezogene Daten sammeln, diese auch auf Anfrage wieder löschen. Und mit einer gesetzlichen Grundlage wie der DSGVO wird das Vergessen von Informationen zu einer grundlegenden Anforderung an Modelle in der Praxis. Es konnte bereits gezeigt werden, dass durch Angriffe auf trainierte maschinelle Lernmodelle Rückschlüsse auf Trainingsdaten gezogen werden können, auch wenn diese selbst bereits gelöscht wurden. Dadurch wird klar, dass ein reines Löschen der gesammelten Daten nicht ausreicht, um personenbezogene Daten wirklich zu vergessen. Eine naheliegende Lösung wäre es, das Modell in regelmäßigen Abständen neu zu trainieren. Die in der Zwischenzeit gelöschten Daten können nicht mehr für das Training verwendet werden. Somit wird sichergestellt, dass das Modell keine Informationen mehr über diese enthält. Da dieses Vorgehen in der Praxis jedoch sehr kostspielig ist, bedarf es einer Möglichkeit die Daten aus dem Modell herauszurechnen, ohne das Modell erneut trainieren zu müssen. Sprich, wir benötigen eine Methodik im Maschinellen Lernen, die es uns erlaubt bestimmte Informationen gezielt zu vergessen.

Strategien intentionalen Vergessens

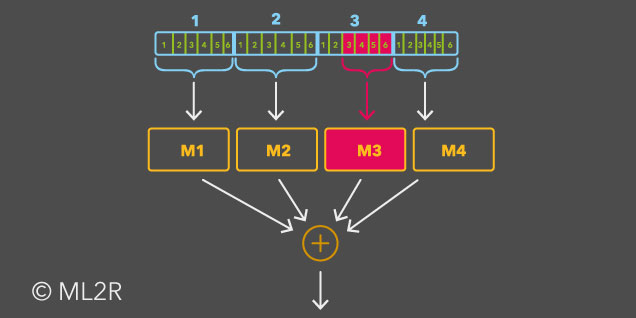

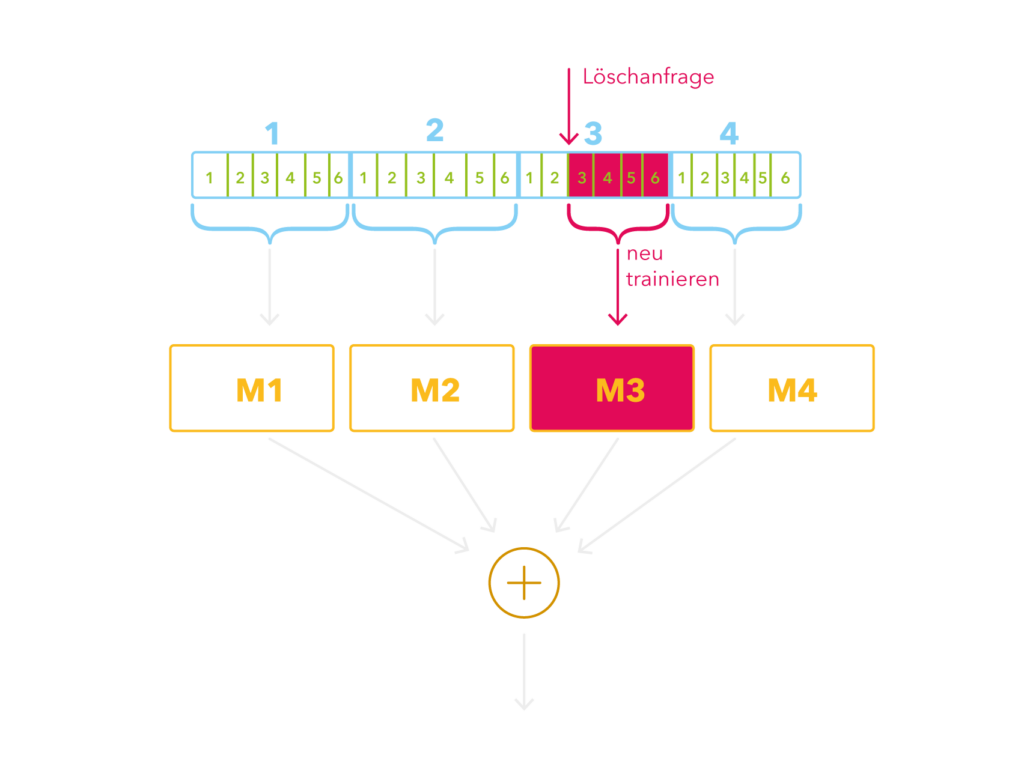

Die erste und vermutlich intuitivere Strategie intentionalen, also vorsätzlichen, Vergessens ist es, den Aufwand eines erneuten Trainings drastisch zu reduzieren. Eine konkrete Umsetzung dieser Strategie bildet das SISA (Sharded, Isolated, Sliced, Aggregated) Training. Dabei werden die Daten in etwa gleichgroße Teile aufgeteilt (Sharded) und für das Training von mehreren Kopien des Modells verwendet. Jedes dieser Modelle wird unabhängig von den anderen (Isolated) trainiert. Dabei wird jeder Teildatensatz in noch kleinere Teile unterteilt (Sliced), die dann nach und nach zum Training hinzugezogen werden. Und schließlich werden die Ergebnisse der einzelnen Modelle für eine gemeinsame Vorhersage kombiniert (Aggregated). Kommt es zu einer Löschanfrage, wird nur noch jenes Teilmodell neu trainiert, das die entsprechenden Daten während des Trainings gesehen hat. Das Training des Teilmodells kann aufgrund der weiteren Aufteilung (Sliced) von dem Zeitpunkt neugestartet werden, an dem der entsprechende Datenpunkt zum Training hinzugenommen wurde.

Beispielabbildung für das SISA (Sharded, Isolated, Sliced, Aggregated) Training. Kommt es zu einer Löschanfrage eines Datenpunkts im dritten Shard und dritten Slice (hier in rot markiert), muss lediglich M3 neu trainiert werden. Das Training wird dabei dort wiederaufgenommen, wo der dritte Slice hinzugezogen wird. Die Slices 1 und 2 müssen nicht erneut trainiert werden.

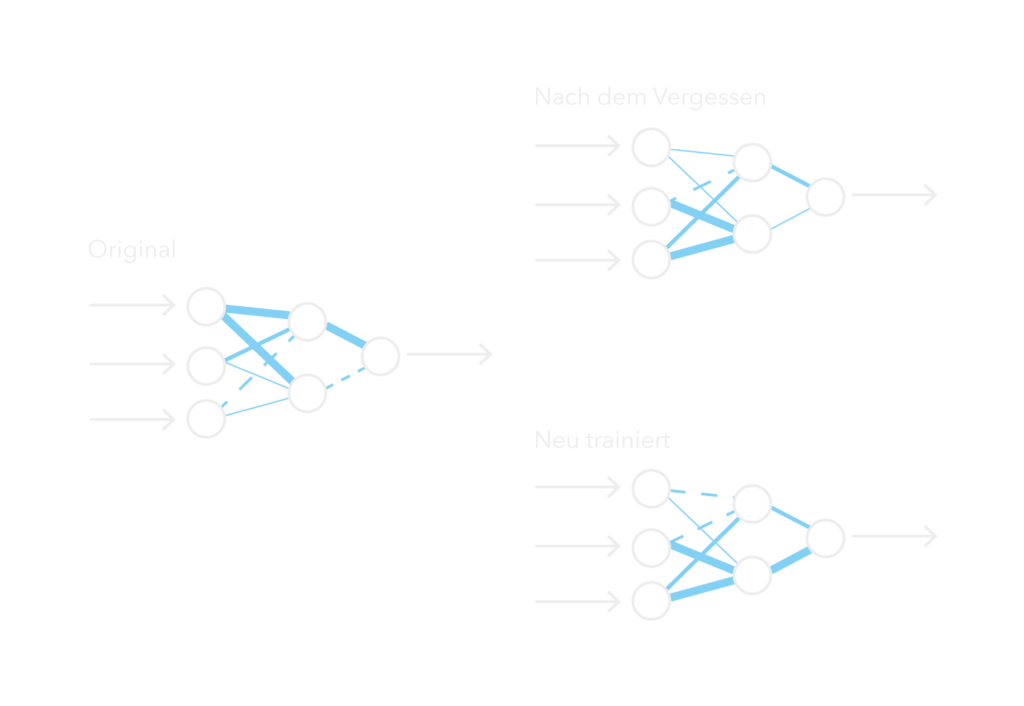

Die zweite Strategie orientiert sich an der Grundidee der differentiellen Privatsphäre (engl. Differential Privacy). Das Modell sollte nach dem Vergessen kaum oder gänzlich nicht von einem Modell unterscheidbar sein, welches die zu vergessenen Daten niemals gesehen hat. Gleichzeitig soll das Modell natürlich keine Informationen über die restlichen Daten verlieren.

Durch das Vergessen von Information wollen wir ein Modell erzielen, das sich kaum oder gar nicht von einem Modell unterscheidet, das ohne die sensiblen Daten trainiert wurde. Die Ähnlichkeit der Modelle wird anhand der Parameter gemessen, hier dargestellt durch die Stärke der Kanten.

Wie die Parameter des Modells angepasst werden müssen, um beiden Bedingungen gerecht zu werden, wird anhand der übrig gebliebenen Daten bestimmt. Diese Strategie vermeidet durch das einmalige Anpassen der Parameter ein erneutes Training vollständig. Im Gegenzug wird dafür in der Regel kein perfektes Ergebnis erzielt. Es bleibt also ein gewisses Restrisiko erhalten, dass die zu vergessenen Informationen weiterhin aus dem Modell wiedergewonnen werden können. Zwei bekannte Ansätze, die diese Strategie verfolgen, sind das Certified Data Removal und das Fisher Forgetting.

Fazit und Ausblick

Wir haben gesehen, dass Vergessen eine wichtige Grundfunktion ist, die es Lebewesen unter anderem ermöglicht von ihren Erfahrungen zu abstrahieren und diese somit besser auf neue Situationen anzuwenden. Aus Perspektive des Maschinellen Lernens wird gezieltes Vergessen zurzeit immer unter dem Gesichtspunkt von Datenschutz und Privatsphäre betrachtet, nicht zuletzt aufgrund gesetzlicher Grundlagen wie der DSGVO. Als Alternative zum erneuten Trainieren haben wir zwei grundlegende Strategien des Vergessens beleuchtet, die den Aufwand eines erneuten Trainings reduzieren oder sogar vollständig vermeiden. Schließt man jedoch erneut den Kreis vom Maschinellen Lernen zu den Neurowissenschaften, so wird schnell klar, dass Vergessen potentiell auch eine weitaus tragendere Rolle zukommen könnte. In Zukunft könnten biologisch inspirierte Vergessensmethodiken entwickelt werden, die es uns erlauben Modelle noch besser in hochdynamischen Szenarien anzuwenden. Im Bereich des Reinforcement Learning und der Robotik könnten Problemlösungen unter plötzlicher Einschränkung der ausführbaren Aktionen gefunden werden. Und nicht zuletzt könnte Vergessen auch eine wichtige Rolle für die Weiterentwicklung allgemeinerer Lernmodelle, wie beispielsweise GPT-3, spielen.