Entdecken. Lernen. Anwenden.

Der Blog für Maschinelles Lernen & Künstliche Intelligenz.

Für Einsteiger*innen

Lernen Sie in dieser Rubrik die Grundlagen von ML, KI und verwandten Bereichen kennen. Hier vermitteln wir ein solides Verständnis der Schlüsselkonzepte und -techniken, die sowohl für Anfänger*innen als auch für erfahrene Enthusiast*innen auf diesem Gebiet wichtig sind.

Für Profis

Entdecken Sie die neuesten Erkenntnisse und Innovationen im Bereich Maschinelles Lernen und Künstliche Intelligenz. In dieser Kategorie befassen wir uns eingehend mit bahnbrechenden Studien, Methoden und Trends, die die Landschaft von KI prägen.

Für Praktiker*innen

Wir schlagen die Brücke zwischen Wissenschaft und praktischer Anwendung. Erfahren Sie, wie Spitzenforschung genutzt wird, um konkrete Herausforderungen in verschiedenen Branchen und Bereichen zu bewältigen.

Thema des Monats

Jeden Monat ein neues Thema im Fokus

In unseren Reihen haben wir insbesondere aktuelle Themen aufgegriffen. Erfahren Sie, was Expert*innen zu den Auswirkungen von KI auf verschiedene Lebensbereiche sagen, erhalten Sie einen Einblick in die Fähigkeiten von ChatGPT oder lesen Sie über das Innovationspotenzial von KI in der Robotik. Wir wünschen Ihnen viel Spaß bei der Entdeckung dieser und vieler weiterer Themen!

Beginnen wir mit einem Ausflug in die Welt der Erklärbarkeit von ML-Methoden in der Wissenschaft!

Grundlagen

Für Einsteiger*innen: Hier erklären wir Begriffe und grundlegende Konzepte des Maschinellen Lernens und der Künstlichen Intelligenz.

Forschung

Für Profis: Unsere Autor*innen berichten über Forschungstrends und ihre aktuellen wissenschaftlichen Arbeiten zum Maschinellen Lernen.

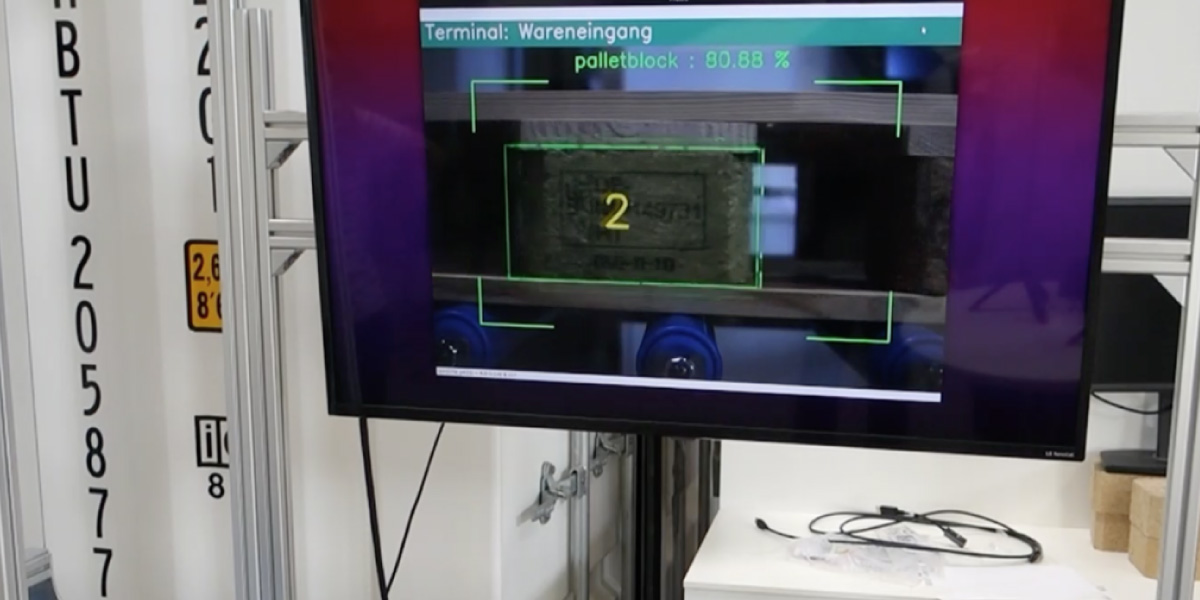

Anwendung

Für Praktiker*innen: Hier geht es um Wissenstransfer. Wir schlagen die Brücke zu praktischen Anwendungen in Wirtschaft und Gesellschaft.

Unsere Reihen

Redaktionsteam

Wir sind Ihre Ansprechpartner*innen, wenn Sie Ideen einbringen oder selbst einen Blogbeitrag schreiben möchten!