In unserem letzten Artikel wurden Chatbots und ihre automatische Bewertung mittels Sprachmodellen wie GPT2, BERT und XLNet kurz vorgestellt. Dort wurde über die Wichtigkeit von Open-Domain-Dialog-Systemen gesprochen. Es wurde gezeigt, wie durch Sprachmodelle (LM) geschlussfolgerte Wahrscheinlichkeiten mit den menschlichen Bewertungsergebnissen korrelieren und daher für die Einschätzung der Dialogqualität geeignet sind.

Wie bereits erörtert, gibt es verschiedene Kriterien anhand derer man eine Konversation bewerten könnte. Eine Antwort kann sich beispielsweise einer fließenden Sprache bedienen, aber völlig inkohärent sein, das bedeutet, ohne Bezug auf den vorangegangenen Kontext zu nehmen. Die LM-basierte Bewertung ist so lange praktisch wie sie keine Überwachung benötigt. Jedoch hat es auch einen großen Nachteil – es stellt nur einen einzigen Score über die gesamte Qualität dar, ohne dass einzelne Kriterien wie Flüssigkeit oder Zusammenhang des Textes berücksichtigt werden.

Aber keine Angst, es gibt eine Lösung für diese Herausforderung! Bevor jedoch die Frage beantwortet werden kann, muss eine Grundlage geschaffen werden: Im Zusammenhang mit KI und ML stößt man fast immer auf Benchmarking, unabhängig von den Teilbereichen. Im Natural Language Processing hat ein Trend auch die Forschung und Entwicklung von Sprachmodellen wie BERT, XLNet und vielen anderen vorangetrieben. Das General Language Understanding Evaluation (GLUE) Benchmark stellt Ressourcen für die Schulung, Bewertung und Analyse von Natural Language Understanding Systemen bereit. Es enthält insgesamt elf Aufgaben, die darauf abzielen, die Sprachverständnisfähigkeiten eines Systems zu bewerten. Das bekannteste Beispiel ist die Stimmungsanalyse (Sentimentanalyse): Hierbei kennzeichnen die Systeme Sätze als positiv oder negativ. Ein anderes Beispiel ist die Detektion von doppelten Fragen: Die Systeme müssen entscheiden, ob zwei Fragen semantisch identisch oder ähnlich sind.

Wie kann GLUE uns dabei helfen die Dialogqualität zu bewerten? Inzwischen haben Sie vielleicht erraten, dass ein ML-Modell, das bei Corpus of Linguistic Acceptability gut abschneidet, auf die Flüssigkeit eines Satzes schließen kann. In ähnlicher Weise werden paarweise Satzaufgaben wie das Erkennen von Textverknüpfungen (engl.: Recognizing Textual Entailment) oder das semantische Textähnlichkeits-Benchmark (engl.: Semantic Textual Similarity Benchmark – STSB) verwendet, um zu prüfen, ob eine Antwort mit dem vorangehenden Dialogkontext kohärent ist. Jede der paarweisen Satzaufgaben sucht nach verschiedenen semantischen Beziehungen, die auch Dialoge modellieren können. Da das Winograd-NLI (WNLI), eine Abwandlung des Winograd-Schemas, und das Multi-Genre Natural Language Inference (MNLI) nicht ohne weiteres auf das Problem der Dialogevaluation abgestimmt werden können, werden sie an dieser Stelle nicht verwendet.

Als erstes braucht man Modelle, die auf die GLUE-Aufgaben trainiert sind. Es wurde eine Abkürzung genommen, indem man fine-getunte BERT-Instanzen wiederverwendet, welche Teile des TextAttack-Frameworks und auf dem HuggingFace ModelHub verfügbar sind. BERT wird genutzt, da es eine bewährte Herangehensweise darstellt. Jedoch ist es denkbar, dass man jede neuronale Architektur verwenden können sollte. Um die Idee zu validieren, hat man Experimente mit Daten durchgeführt, die wissensbasierte, von Menschen bewertete Gespräche beinhalten. Die Bewertung erfolgte über sechs Kriterien, die zeigen sollten, wie (1) verständlich, (2) natürlich, (3) kontextbezogen, (4) interessant und (5) wissensbasiert der Text war. Ebenfalls wurde die (6) Gesamtqualität des Dialogs als Kriterium aufgenommen. Anschließend wurden die Wahrscheinlichkeiten mit den menschlichen Annotationen abgeglichen.

Wie erwartet sind hier Pearson und Spearman Korrelationskoeffizienten von bis zu 0,7. Außerdem haben zum Beispiel die Kriterien wissensbasiert und STSB Korrelationsraten von 0,7329 bzw. 0,7173. Auch bei der Verwendung von STSB erhält man Korrelationen von 0,3620 und 0,3463 mit dem Kriterium kontextbezogen. Aber das ist noch nicht alles!

Jetzt hat man Qualitätsindikatoren für jedes der Kriterien. Es wäre auch gut, eine Mischung aus diesen Indikatoren zu haben, die die Gesamtqualität anzeigt, da die einzelnen Indikatoren nicht so gut korrelieren. Dazu wurde eine lineare Regression durchgeführt und dabei die einzelnen GLUE-Aufgaben als abhängige Variablen und die Gesamtqualitätskriterien als Zielgröße verwendet. Der zusammengesetzte Indikator weist Korrelationskoeffizienten von fast 0,5 auf. Im Gegensatz dazu erreicht die beste einzelne GLUE-Aufgabe nur 0,4.

Alle diese Korrelationskoeffizienten implizieren eine Beziehung zwischen den Variablen. Im letzten Beispiel bedeutet ein Wert von 0,5, dass die lineare Regression für jede Einheit der Erhöhung des Gesamtkriteriums um die Hälfte reagiert. Mit anderen Worten: Wenn der Bewerter die Punktzahl um 0,1 erhöht, sollte das Modell dies um 0,05 tun.

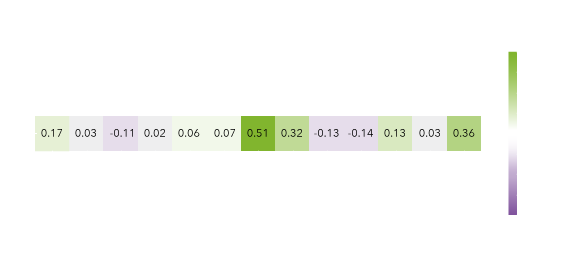

In der folgenden Abbildung sind die gelernten Gewichte der linearen Regression dargestellt:

Fazit

Man sieht, dass viele dieser Aufgaben einen Einfluss haben – Manche sind sogar sehr stark. Die Gewichte mit einem „Fakten“-Präfix berechnet die Werte zwischen der Wissensbasis des Gesprächs und der angestrebten Reaktion. Es ist zu sehen, dass die Aufgaben zur semantischen Überschneidung, wie der Microsoft Research Paraphrase Corpus und STSB die stärkste Rolle haben. Die Beobachtung gilt sowohl für die Messung der Aufgaben am Dialogkontext als auch an der Wissensbasis.

Zusammenfassend lässt sich sagen: Die Korrelationskoeffizienten sind zwar gut, aber es gibt noch Raum für Verbesserungen. In Zukunft wird man sich mit anderen derartigen Benchmarks befassen, die möglicherweise zusätzliche Verbesserungen bringen könnten.

Mehr in der zugehörigen Publikation:

Proxy Indicators for the Quality of Open-domain Dialogues

Rostislav Nedelchev, Jens Lehmann, Ricardo Usbeck, Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing, 2021, PDF

Link zum Code: https://github.com/SmartDataAnalytics/proxy_indicators

Dies war ein Gastbeitrag des SDA Blogs. Hier geht es zur englischen Version des Blogbeitrags: Link