Wenn künstliche Intelligenzen Entscheidungen treffen müssen, können sie leicht zum Opfer feindlicher Angriffe werden. Wie einfach ein Angreifer es hierbei hat, hängt von der Form der Grenze ab, mit der das neuronale Netz die möglichen Entscheidungen von einander trennt. In unserer Publikation „Heating Up Decision Boundaries“ messen wir die Hitze, die eine solche Grenze absondert und folgern daraus ihre Form.

Neuronale Netze sind heutzutage tief verwoben in unseren Alltag und führen zahlreiche Aufgaben mit einer für Menschen unerreichbaren Präzision aus. Umso überraschender ist, dass sie Opfer von Attacken werden können, auf die ein Mensch nie hereinfallen würde.

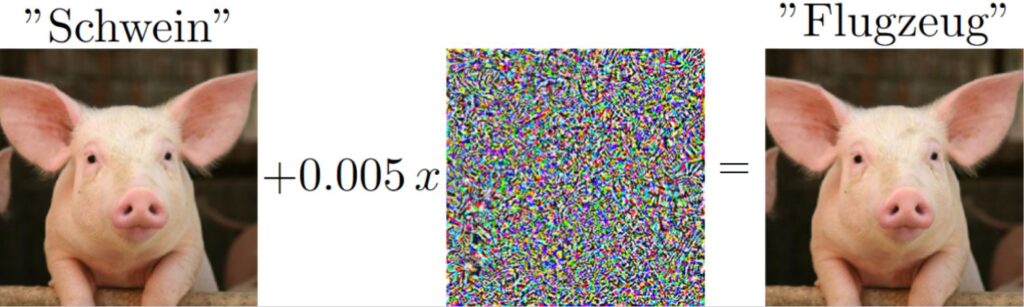

In diesem Beispiel wären sich beim linken Bild Mensch und Maschine einig – es handelt sich um ein Schwein. Das Hinzufügen eines bestimmten Rauschens überzeugt die Maschine jedoch davon, dass sie ein Flugzeug vor sich hat, während das menschliche Auge keinen Unterschied zwischen den Bildern sieht. Was ist hier passiert?

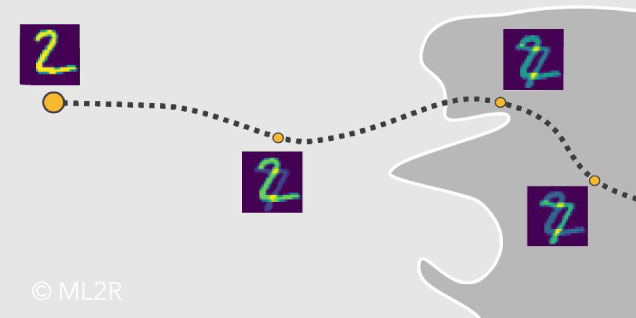

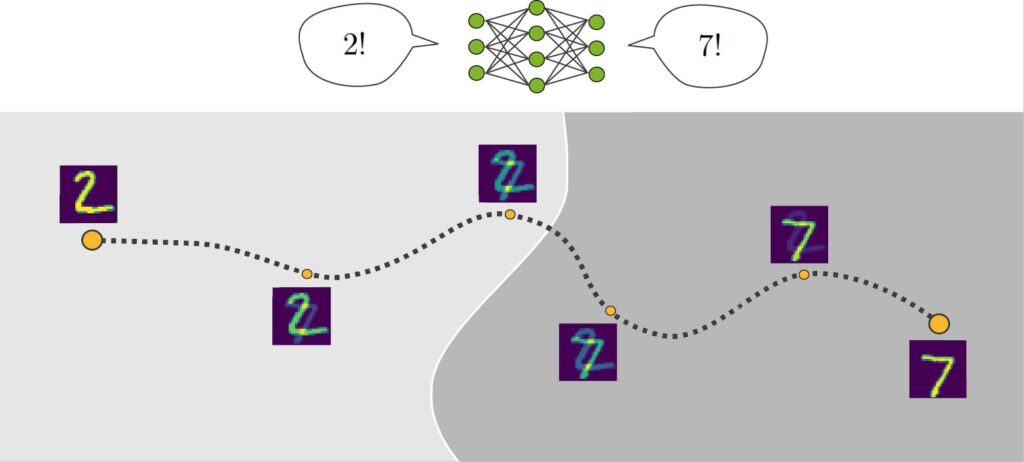

Der kürzeste Weg zur Entscheidungsgrenze

Wir müssen zunächst begreifen, wie neuronale Netze überhaupt Bilder einordnen. In diesem Beispiel klassifiziert das Netz alle handgeschriebenen Ziffern, die im helleren Graubereich liegen als zwei und im dunkleren Graubereich liegen als Sieben. An welchem Ort eine Ziffer liegt, wird durch die Helligkeit seiner Pixel bestimmt. Von einer Zwei ausgehend, könnten wir nun einzelne Pixel so lange ändern, bis unser Bild eine Sieben zeigt. Fragen wir während des Abwanderns dieses Pfads das neuronale Netz, wie es unser Bild einordnet, muss es einen Punkt geben, an dem es sein Urteil ändert. Diesen Punkt nennen wir die Entscheidungsgrenze, im obigen Bild ist es die weiße Grenzen zwischen dem helleren und dunkleren Graubereich.

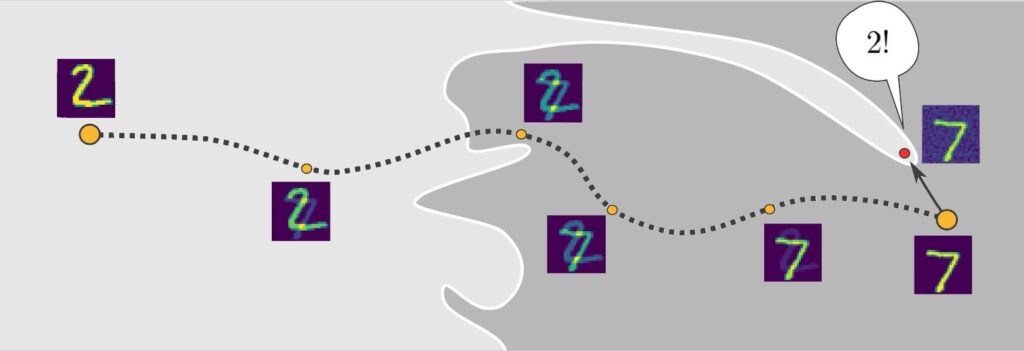

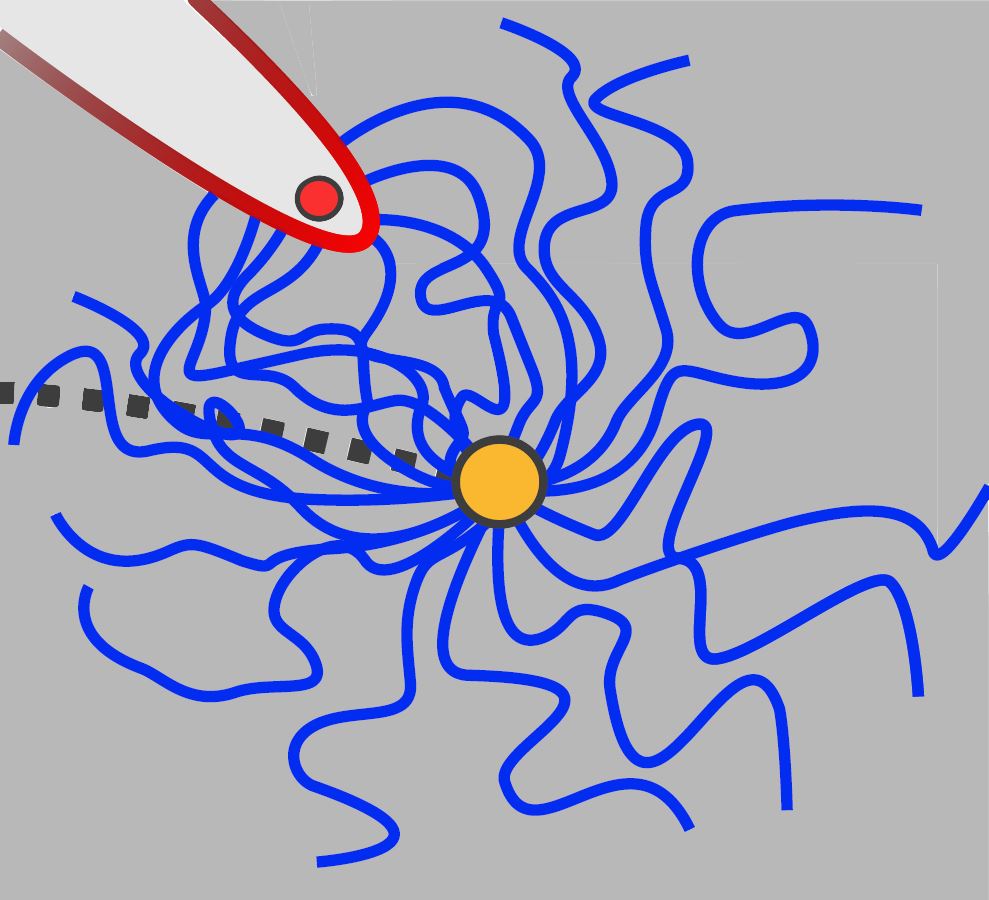

Feindlich gesonnene Algorithmen suchen nach dem kürzesten Weg zur Entscheidungsgrenze, um so durch eine minimale Manipulation des Bildes das Urteil des neuronalen Netzes zu ändern. Im obigen Beispiel hat eine solche Strategie wenig Aussicht auf Erfolg, weil die Grenze näherungsweise glatt ist und stets einen großen Abstand zwischen den Siebenen und den Zweien bewahrt. In diesem Fall nennen wir das Netzwerk robust. Das folgende Netzwerk ist dagegen äußerst anfällig.

Der feindliche Algorithmus kann den Zacken in der Entscheidungsgrenze zu seinem Vorteil nutzen und überschreitet die Grenze schon mit einer minimalen Manipulation der Daten. Einen solchen Zacken scheint es auch im obigen Beispiel mit dem Schwein gegeben zu haben und erklärt, warum die Geometrie von Entscheidungsgrenzen im Zentrum einer lebhaften Diskussion über die Angreifbarkeit von künstlicher Intelligenz steht. Jedoch ist es in realistischen Szenarien extrem aufwändig, Einblicke in diese Geometrie zu erlangen, sodass stetig neue und effiziente Methoden gesucht werden, um unser Verständnis von neuronalen Netzen zu schärfen.

Entscheidungsgrenzen sichtbar machen

Eine solche Methode zur Ermittlung der Geometrie von Grenzen schlagen wir in unserer neuen ICLR-Publikation „Heating Up Decision Boundaries: Isocapacitory Saturation, Adversarial Scenarios and Generalization Bounds“ von unseren ML2R-Forschern Bogdan Georgiev, Lukas Franken und Mayukh Mukherjee (Indian Institute of Technology Bombay) vor. Die Idee ist, die Entscheidungsgrenze als eine Hitzequelle zu interpretieren und die Menge an abgesonderter Wärme in Geometrie zu übersetzen: Den Prozess kann man sich vorstellen wie bei altmodischen Heizungen, deren kantige und spitze Körper versuchen, die Hitze abgebende Fläche zu maximieren. Nach dem gleichen Prinzip gibt auch die Entscheidungsgrenze mehr Hitze ab, wenn sie spitz und uneben ist.

Aber wie können wir diese Erwärmung simulieren? Wir können Hitze physikalisch interpretieren: Was wir als Wärme auf unserer Haut empfinden, sind in Wirklichkeit nur eine Vielzahl winziger Teilchen, die mit der Haut kollidieren – weniger Wärme, weniger Kollisionen und umgekehrt. Diese Intuition können wir auch nutzen, um das Erwärmen von Entscheidungsgrenzen darzustellen. Also repräsentieren wir die Erwärmung durch sich zufällig bewegende Teilchen, die von der Entscheidungsgrenze abgegeben werden und sich im Raum verteilen. Als Messorte nutzen wir die Trainingsbeispiele – Empfangen sie viele Teilchen, erwärmt sich die Entscheidungsgrenze stark, ansonsten weniger.

Allerdings ergibt sich hier ein weiteres Problem, denn wir wissen nicht einmal, wo diese Grenze liegt. Alles was wir wissen, ist, wo die Beispiele, also die Zweien und Siebenen, liegen. In der Praxis messen wir also, wie viel Wärme die Grenze durch die Erwärmung des Beispiels empfängt und nicht umgekehrt. Die Analyse bleibt identisch, weil die beiden Rollen – Wärmestrahler und Wärmeempfänger – austauschbar sind. Dieser Umstand wird durch die Feynman-Kac-Dualität formalisiert. Der Anteil der Teilchen, die während ihrer Bewegung mit der Entscheidungsgrenze kollidieren, entspricht der emittierten Hitze. Mit dieser Methode können wir nicht nur ertasten, ob die Entscheidungsgrenze existiert, sondern auch ob sie flach, rund oder spitz ist. Diese Unterscheidung zu ermessen war bisher keinem der bekannten Verfahren möglich. Tatsächlich war die Forschungsgemeinschaft bisher der Überzeugung, dass robuste Netze dann entstehen, wenn die Entscheidungsgrenzen flach sind. Wir weisen nach, dass dies nicht der Fall ist. Lokal weisen auch robuste Netze spitze Oberflächen auf, ihre Robustheit scheint also durch schwer nachweisbare andere Eigenschaften erzeugt zu werden. In dem Sinne vertiefen wir unser Verständnis der Angreifbarkeit neuronaler Netze.

Rückschlüsse auf Verallgemeinerungsfähigkeit neuronaler Netze

Tatsächlich ist Robustheit gegen Widersacher nicht die einzige Eigenschaft, die beeinflusst wird von der Geometrie der Entscheidungsgrenzen. Wir zeigen auch, dass die Geometrie Hinweise dafür liefert, wie gut ein neuronales Netz verallgemeinert. Die Fähigkeit zu verallgemeinern ist der Hauptgrund für die Nützlichkeit von Maschinellem Lernen. Sie bedeutet exemplarisch, dass wir einem Netzwerk Beispiele für handgeschriebene Dreien zeigen können und es anschließend dazu in der Lage ist Dreien zu erkennen, obwohl es nicht die Dreien aus dem Training sind. Könnte das Netzwerk von den gelernten Beispielen nicht verallgemeinern, wäre es nicht dazu in der Lage Ähnlichkeit zu erkennen, sondern nur, ob ein Beispiel exakt identisch ist zu einem bereits gesehenen Beispiel. Es stellt sich heraus, dass die Eigenschaft gut verallgemeinern zu können eher gewährleistet ist, wenn Entscheidungsgrenzen a) flach und b) weit entfernt von den Trainingsbeispielen sind. Unsere Methode bietet Möglichkeiten, Einsichten in beide Eigenschaften zu erlangen.

Wie Entscheidungsgrenzen in angreifbaren oder robusten neuronaler Netze geformt sind, ist seit einigen Jahren ein aktives Forschungsthema. Unsere Technik, die Entscheidungsgrenzen zu erhitzen und von der Menge emittierter Hitze ihre Form zu folgern, bereichert den aktuellen Kenntnisstand zu diesem Thema: Selbst robuste Netze weisen lokal spitze und zackige Oberflächen auf. Es gibt sogar noch weitere Eigenschaften, die durch die Geometrie von Entscheidungsgrenzen ermittelt werden können. Hierzu gehören beispielsweise die allgemeine Qualität der Klassifizierung oder die Menge an Parametern, die für die Funktionalität des Netzes eine Rolle spielen. In zukünftigen Projekten werden wir diese Zusammenhänge genauer untersuchen.

Mehr Informationen in der zugehörigen Publikation:

Heating up decision boundaries: isocapacitory saturation, adversarial scenarios and generalization bounds B. Georgiev, L. Franken, M. Mukherjee, ICLR, 2021, PDF.