In den Forschungs- und Entwicklungsabteilungen kann Design of Experiments mit Künstlicher Intelligenz viele Experimente, und damit Zeit, Geld und Ressourcen sparen. Doch wie genau funktioniert es?

Das Problem – zu viele Möglichkeiten

Viele Menschen in den Forschungs- und Entwicklungsabteilungen dieser Welt stehen vor ein- und derselben Aufgabe: etwas Neues entwickeln. Wie kann eine Batterie aussehen, die ein Elektroauto noch länger fahren lässt? Wie kann der Rotor einer Windkraftanlage verändert werden, dass er weniger Schallemissionen verursacht? Wie sieht ein neues Waschmittel aus, das sauber wäscht aber weniger Ressourcen verbraucht? Die möglichen Antworten auf diese Fragen sind häufig sehr vielfältig. Es gibt (zu) viele Möglichkeiten, wie bestehende Technik verändert oder verbessert werden könnte.

Leider können nicht alle Ideen ausprobiert werden, denn jedes Experiment, egal ob Simulation oder ganz real im Labor, kostet Zeit, Geld und Ressourcen. Für Forschende wäre es ein Traum, alle Experimente durchführen zu können, doch auch sie arbeiten nur mit begrenzten Mitteln.

Design of Experiments – eine Lösung

Hier kommt das Design of Experiments (DoE) ins Spiel. Die Grundidee ist einfach: Kann eine gute Versuchsplanung (= engl. Design of Experiments) dabei helfen, weniger Experimente zu benötigen? Wie kann geprüft werden, ob ein bestimmter Faktor überhaupt Einfluss auf die Zielgröße hat? Und wie kann die Größe des Einflusses des Faktors abgeschätzt werden? Mit einem guten DoE sollten nur noch die statistisch notwendigen, nicht alle möglichen Experimente durchgeführt werden.

Wichtig ist hier, auch den Bezug zum Curse of Dimensionality herzustellen. Hierzu kann man sich einen Kaffeevollautomaten vorstellen, dessen (unbekannte) Schalter (= Faktoren) man kennenlernen möchte: Jeder zusätzliche Faktor (zum Beispiel: Mahlgrad, Wassertemperatur, Brühdauer, …) erhöht die Dimension und damit gleichzeitig die Anzahl der Experimente, die gemacht werden können und müssen, um beispielsweise den schmackhaftesten Espresso zu finden, den die Maschine hergibt. Das exponentielle Wachstum der Punkte, um den Raum zu füllen (hier: der Experimente, um statistisch valide Schlüsse zu ziehen), wird als Curse of Dimensionality bezeichnet.

Ein gutes DoE dient jetzt dazu, nur noch die notwendigen Experimente zu machen und den Einfluss des Curse of Dimensionality zu verringern. Dafür müssen zunächst Annahmen getroffen werden: Ist der Einfluss des Faktors eher monoton (je länger gebrüht wird, desto stärker der Kaffee) oder zum Beispiel quadratisch (sehr grobe Bohnen erzeugen einen schlechten Kaffee, sehr fein gemahlene Bohnen auch, dazwischen liegt ein Optimum)? Davon ausgehend kann man ein erstes DoE aufsetzen, das diese Annahmen prüft: Für die Brühdauer braucht man mindestens zwei Variationen (niedrig/hoch), für den Mahlgrad drei (niedrig/mittel/hoch). Hieraus ergeben sich sechs notwendige Experimente: die Variation der Brühdauer bei allen drei Mahlgraden. Wenn man zusätzlich annimmt, dass es keine Interaktion zwischen den beiden Größen gibt, würden sogar vier reichen – zwei bei einem festen Mahlgrad, um den Einfluss der Brühdauer festzustellen und drei, bei denen der Mahlgrad bei fester Brühdauer variiert wird.

Auf den ersten Blick ist dieses Vorgehen sehr einleuchtend – es verkompliziert sich jedoch, wenn die Formulierung der Hypothesen (hier die Monotonie oder die Polynomannahme) nicht mehr so einfach ist und die Anzahl der Faktoren wächst. An dieser Stelle hilft DoE, die wirklich notwendigen Experimente aus den möglichen auszuwählen.

Fixed-size und sequential Design of Experiments

Lösungen für dieses erste Problem gibt es schon lange in den Ingenieurwissenschaften und man findet bereits eine entsprechende Literaturauswahl. Jedoch haben diese Lösungen eine Gemeinsamkeit: sie erzeugen sogenannte „Fixed-size Designs of Experiments”. Also Versuchspläne einer festen Größe, die genau zu den aufgestellten Hypothesen passt.

Gleichzeitig wird hierbei die Annahme getroffen, jedes Mal neu anzufangen. Auch wenn die zehnte Kaffeemaschine untersucht werden soll, nimmt das DoE an, dass es sich um eine völlig neue Maschine handelt und der Effekt der Brühdauer völlig anders als bei den vorigen sein kann. Alle Parameter sind völlig neu und aus den alten, verwandten Experimenten kann nicht gelernt werden.

Sequential Design of Experiments begegnet genau dieser Annahme. Die Idee ist, aus alten Messungen zu lernen. Und wie macht das ein Machine-Learner? Mit einem Modell. Damit es funktioniert, müssen daher zwei Dinge gegeben sein: zum einen, ein fixed-size DoE, mit dem man genügend lernen kann und zum anderen, eine gute Modellqualität, welche zum Beispiel in einer Kreuzvalidierung festgestellt werden kann.

Sequential Design of Experiments: Active Learning vs. Bayesian Optimization

Sequential Design of Experiments lernt also aus schon vorhandenen Experimentdaten. Die Frage ist nun, was soll es lernen? Man unterscheidet zwei Ideen:

- Neue Punkte suchen, die das bestehende Modell verbessern, also genauer machen (zum Beispiel: Welchen Einfluss haben Mahlgrad und Brühdauer auf den Kaffeegeschmack?)

- Neue Punkte suchen, die eine Einschätzung geben können, wo das Optimum liegt (zum Beispiel: Welchen Mahlgrad und welche Brühdauer brauche ich für den besten Kaffee?)

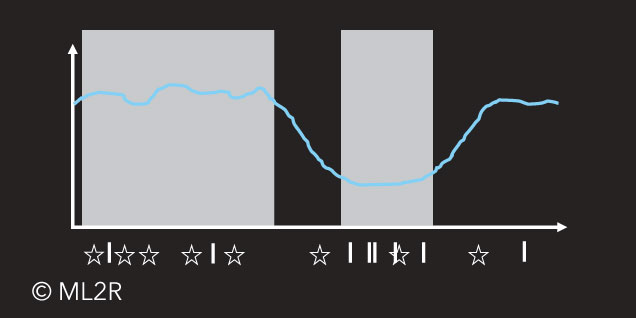

1) Active Learning: konzentriert sich sukzessive auf die interessanten Stellen der Funktion, zum Beispiel starke Schwankungen, Sprünge (☆)

2) Bayessche Optimierung: konzentriert sich sukzessive auf das Minimum der Funktion (I)

Diese Ideen unterscheiden sich fundamental, wie man auch im Bild erkennen kann. Die erste Idee interessiert sich für Faktorbereiche, in denen „viel“ passiert. Hier helfen Methoden des Active Learnings, diese Bereiche zu bestimmen und die richtigen Punkte auszuwählen. Die zweite Idee interessiert sich für Faktorbereiche, in denen der Funktionswert besonders optimal (niedrig oder hoch, je nach Wahl durch den Anwender) ist. Dabei kann zum Beispiel Bayessche Optimierung weiterhelfen.

Die Konsequenzen von gutem Design of Experiments

Design of Experiments ist also eine Methode, welche die notwendigen Daten in der Forschung und Entwicklung generieren kann. Sie vermag Kosten sowie Ressourcenverschwendung zu reduzieren und so „methodisch intelligent“ zu forschen. In Kundenprojekten konnten wir bereits zeigen, dass mittels sequential DoE bis zu 50 % der Versuche eingespart werden können.

Schon früher diente DoE dazu, den Einfluss von Größen in immer neuen Problemen zu spezifizieren. Heute kann es aus bestehenden Daten lernen, um interessante Bereiche zu finden. Dazu baut es auf Machine Learning Modellen auf – und weil es neue Experimente selbstständig vorschlägt, ist es eine echte künstliche Intelligenz.

Weitere Informationen in der zugehörigen Literatur:

Statistics for Experimenters: Design, Innovation, and Discovery (2nd Edition)

Box, G. E., Hunter, W. H., & Hunter, S., Wiley-Interscience, 2005, Link

Design and Analysis of Experiments (10th Edition)

Montgomery, D. C., Wiley, 2019, Link

The Design of Experiments Fisher, R. A., Nature 137, 252–254, 1936, Link

[/vc_column_text][vc_separator align=“align_left“ el_width=“80″ css_animation=“slideInLeft“ css=“.vc_custom_1606228786454{margin-top: 40px !important;margin-bottom: 40px !important;}“][vc_btn title=“Kontakt“ style=“flat“ align=“left“ i_align=“right“ i_icon_fontawesome=“far fa-paper-plane“ css_animation=“fadeInLeft“ add_icon=“true“ link=“url:mailto%3A%20ml2r-contact%40iais.fraunhofer.de“ css=“.vc_custom_1606228831971{margin-bottom: 40px !important;}“][/vc_column][/vc_row]