In diesem Beitrag gibt Dr. Maximilian Poretschkin, Wissenschaftler und Teamleiter KI-Absicherung und -Zertifizierung am Fraunhofer IAIS, einen kompakten Überblick über das Thema der Vertrauenswürdigkeit Künstlicher Intelligenz und warum es wichtig ist, dass standardisierte Prüfverfahren für KI-Systeme etabliert werden. Dabei gibt er nicht nur Antwort auf die Frage „Was muss geprüft werden?“, sondern geht auch darauf ein, warum es unerlässlich ist, die Vertrauenswürdigkeit eines KI-Systems sicherzustellen und nachzuweisen.

Künstliche Intelligenz (KI) dringt in immer mehr Bereiche unseres Lebens vor und übernimmt dabei zunehmend verantwortungsvolle Tätigkeiten, etwa bei hochautomatisierten Fahrassistenzsystemen, bei Anwendungen zur medizinischen Bildauswertung, zur Prozessautomatisierung bei Versicherungen oder für Kreditwürdigkeitsprüfungen bei Banken. Dabei wird der Einsatz von KI in sensiblen Bereichen nur dann genügend Akzeptanz finden, wenn Endanwender*innen und Betroffene darauf vertrauen können, dass solche KI-Anwendungen korrekt funktionieren und nach hohen Qualitätsstandards entwickelt wurden. Einen bewährten Weg, Vertrauen zu schaffen, stellen unabhängige Prüfungen von KI-Anwendungen (durch eine unabhängige Partei) dar. Als Ergebnis einer solchen Prüfung kann ein Bericht, Gütesiegel oder Zertifikat stehen, welches die Erfüllung von Qualitätsstandards von KI-Systemen für Dritte nach außen hin sichtbar macht. Auch der aktuelle Gesetzesentwurf der Europäischen Kommission zur Regulierung von KI-Systemen fordert eine Prüfung von KI-Anwendungen mit einem hohen Risiko.

Was muss geprüft werden?

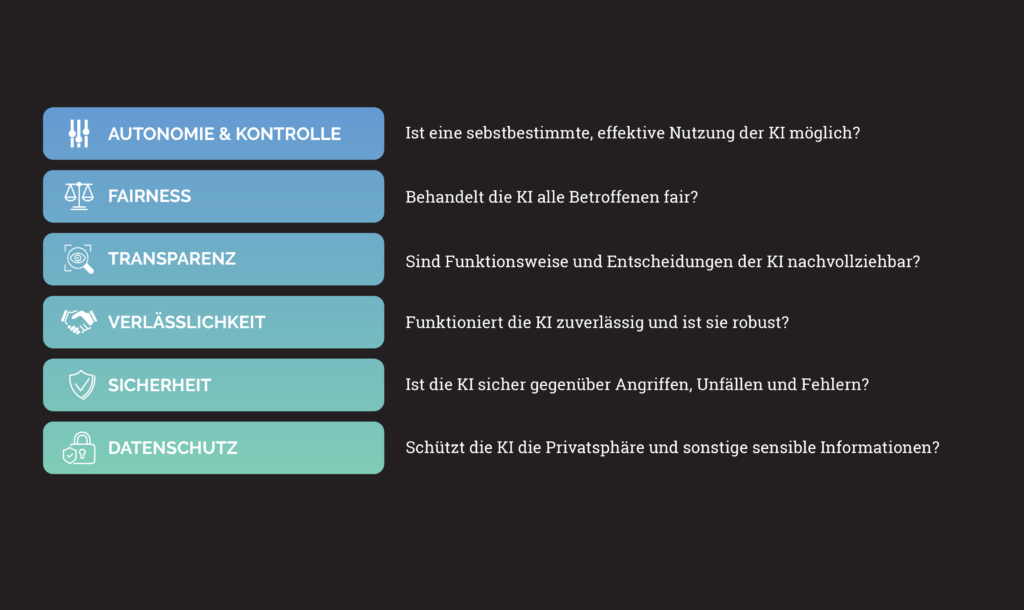

Für die Realisierung solcher KI-Prüfungen stellt sich als erstes die Frage, gegen welche Anforderungen eine KI-Anwendung geprüft werden soll. Diese Anforderungen werden durch den Begriff der KI-Vertrauenswürdigkeit zusammengefasst, welcher die folgenden Dimensionen umfasst:

Die KI-Vertrauenswürdigkeit umfasst mehrere Dimensionen u.a. Kontrolle, Transperenz und Sicherheit.

Weiterführende Informationen zu KI-spezifischen Handlungsfeldern für den vertrauenswürdigen Einsatz von Künstlicher Intelligenz finden Sie in diesem Whitepaper des Fraunhofer IAIS. Darüber hinaus bieten die “Ethics Guidelines for trustworthy AI” der High-Level Expert Group on Artificial Intelligence (HLEG AI) der europäischen Kommission einen ersten Entwurf für Leitlinien einer Vertrauenswürdigen KI.

Im Einzelfall sind nicht alle Anforderungen für alle KI-Anwendungen gleichermaßen wichtig, sondern hängen von dem Einsatzkontext der KI-Anwendung ab. Es ist etwa sehr unwahrscheinlich, dass eine Anwendung zur prädiktiven Wartung von Maschinen Nutzer*innen dieser Anwendung ungerechtfertigt diskriminieren wird, in diesem Fall ist die Dimension „Fairness“ also von geringerer Bedeutung. Für eine KI-Anwendung, welche bei der Beurteilung der Kreditwürdigkeit unterstützt, ist das „Fairness“-Risiko aber nicht zu vernachlässigen und sollte unbedingt bei der Beurteilung einer solchen Anwendung untersucht werden.

Warum ist die Entwicklung von KI-Prüfungen ein Fall für die Forschung?

KI-Anwendungen beruhen im Kern auf Software, welche durch Künstliche Intelligenz, zum Beispiel ein ML-Modell, realisiert wird. Während es viele etablierte Verfahren gibt, um Software systematisch zu testen und zu prüfen, greifen diese im Fall von KI zu kurz. Ein wesentlicher Grund ist, dass viele KI-Anwendungen (insbesondere ML-Modelle) datengetrieben sind und ihre innere Logik aus einer Anpassung bestimmter Parameter an große Datenmengen erlernen. Hieraus ergeben sich eine Reihe an Herausforderungen für die Forschung, im Folgenden werden zwei prominente Fragestellungen kurz dargestellt:

Validierung von KI-Anwendungen: „Herkömmliche Software“ ist typischerweise modular aufgebaut, so dass sie zum Testen in kleine Einheiten zerlegt werden kann, die systematisch getestet und die Testergebnisse der einzelnen Einheiten zu einer Aussage für die gesamte Software aggregiert werden können. Dies ist im Fall von KI nicht ohne weiteres möglich: Ein Neuronales Netz kann üblicherweise nicht in einzelne Komponenten zum Testen zerlegt werden. Es kann also nur als Ganzes getestet werden, was den Testvorgang sehr komplex macht. Insbesondere für Netze, die mit einer sehr großen Menge an möglichen Eingabedaten zurechtkommen müssen (wenn der mögliche Eingaberaum prinzipiell beliebig groß wird, spricht man auch von einem Open-World-Kontext), ist eine Aussage, wie groß die Testabdeckung ist, sehr schwierig. Hierzu gibt es unterschiedliche Lösungsansätze: Für spezielle Netzwerkarchitekturen, Aktivierungsfunktionen und Spezifikationen des Eingaberaums ist es möglich, mathematisch beweisbare Aussagen über Begrenzungen des Raumes der möglichen Ausgaben zu machen. Für viele KI-Anwendungen ist dieser Ansatz aber noch nicht praktikabel und so fokussiert sich die Forschung darauf, Ansätze zum systematischen Testen zu entwickeln.

Lernen im Betrieb: KI-Anwendungen, die auf dem Einsatz von ML-Modellen beruhen, können – zumindest im Prinzip – auch während des Produktiveinsatzes weiterlernen. Daneben kann eine KI-Anwendung auch nach abgeschlossenem Lernprozess ihr Verhalten ändern, nämlich dann, wenn sich ihre Einsatzumgebung ändert und die zu verarbeitenden Eingangsdaten nicht mehr strukturidentisch zu den Trainingsdatensätzen sind. Dies stellt herkömmliche Prüfverfahren vor eine Herausforderung, denn ein Prüfergebnis zu einem festen Zeitpunkt kann seine Gültigkeit verlieren, wenn der Prüfgegenstand danach signifikant verändert wird. Somit ist die Entwicklung von Verfahren notwendig, welche eine kontinuierliche „Echtzeit“-Prüfung von KI-Systemen ermöglichen.

Die Fortschritte bei der Beantwortung dieser Fragestellungen müssen kontinuierlich Eingang in die Standardisierung finden, da Standards und Normen die Referenzgrößen bilden, gegen die Prüfungen stattfinden. Auch an dieser Stelle besteht noch ein großer Handlungsbedarf wie die Normungsroadmap KI von DIN und DKE eindrucksvoll zeigt.

Welche Lösungsansätze gibt es?

Wirft man einen Blick auf Prüfverfahren aus benachbarten Domänen, etwa die IT-Sicherheit, so zeigt sich, dass es grob gesprochen zwei prominente Ansätze gibt, um Prüfungen zu realisieren: Prozess- und Produktprüfungen. Erstere Art von Prüfung adressiert die Prozesse, nach denen KI-Anwendungen entwickelt und betrieben werden und beruht auf der Annahme, dass gute Prozesse auch zu guten KI-Anwendungen führen. Darüber hinaus können viele KI-Anwendungen gar nicht ohne flankierende Prozesse betrieben werden, was die Wichtigkeit solcher Prüfungen ebenfalls unterstreicht. Die zweite Art von Prüfungen zielt darauf ab, die Funktionalitäten einer konkreten KI-Anwendung zu validieren beziehungsweise über eine strukturierte Risikoanalyse nachzuweisen, dass wesentliche Risiken im Hinblick auf die Vertrauenswürdigkeit hinreichend gut gemindert sind. Hierzu hat das Fraunhofer IAIS den ersten KI-Prüfkatalog „Leitfaden zur Gestaltung von vertrauenswürdiger KI“ veröffentlicht, welcher den State of the Art zu den oben vorgestellten Forschungsfragestellungen zusammenfasst und in ersten KI-Prüfungen zum Einsatz gekommen ist.